クローラビリティとは?SEOで重要な理由と向上させる方法

クローラビリティを向上させることはSEO対策での成果を高めることに繋がるため、WEBサイトを運営する上で重要な施策となります。本記事では、クローラビリティの重要性、低いクローラビリティの原因と解決策について詳しく解説します。上級者向けの内容ですが、初心者にも分かるように解説していますので是非最後まで読んでみてください。

クローラビリティとは

クローラビリティ(Crawlability)とは、検索エンジンのクローラーがWEBページを発見できる能力を示す言葉です。

Googleなどの検索エンジンは、インターネット上の情報を収集するためのロボット「クローラー」を使って自動的にWEBページをクロールし、情報を収集しています。

クローラーが収集した情報をインデックスデータベースに格納し、ユーザーが検索したキーワードと関連性の高い情報を持つページを、検索結果に表示しているのが検索エンジンの仕組みです。

そのため、クローラビリティが高い(良い)サイトは、クローラーが迷うことなく全てのページにアクセスでき、多くのページが検索結果に表示されます。

つまり、SEOをおこないWEBサイト内のページを多く検索結果に表示させるためには、クローラビリティを意識して運用をおこなうことが重要となります。

クローラーとは、検索エンジンがインターネット上の情報を自動的に収集するために使用するプログラムやロボットのことです。

クローラーはWEBサイトのリンクを辿りながらページを訪問し、HTML・画像・PDF・CSS・JavaScriptなど様々なファイルを解析してデータベースに保存します。また、クローラーが情報収集をおこなうプロセスを「クロール」と呼びます。

インデックスとは、検索エンジンがクローラーによって収集したWEBページの情報を整理・保存するデータベースのことです。クローラーがWEBサイトをクロールして取得したHTMLファイルや画像、PDFなどのコンテンツは、インデックスに登録されます。

インデックスに登録されなければ、検索結果に表示されることはありません。

クローラビリティがSEOで重要な理由

クローラビリティが悪いWEBサイトは次のような悪影響が発生するため、SEOをおこなう上で重要です。

- ページがクロールされず検索結果に表示されない

- 新規ページや更新したぺージのクロールが遅れ機会損失が発生する

クローラビリティが悪いと、検索エンジンのクローラーがサイト内のページを十分に巡回できないため、ページがクロールされません。ページがクロールされなければ当然インデックスに登録されないため、検索結果にも表示されません。つまりそのページへのアクセスは0です。

そのため、ポータルサイトやニュース系メディアなど数十万ページ以上あるようなWEBサイトの場合は、多くのページを検索結果に表示させる必要があるため、SEOをおこなう上では致命的となります。

また、クローラビリティが悪いと、検索エンジンが新しいページや更新されたページを発見するまでに時間がかかり、検索結果に反映されるまでにタイムロスが発生します。

そのため、話題になっているテーマや最新情報を扱っているWEBサイトの場合は、競合サイトに対して露出が遅れ機会損失が発生します。

では、クローラビリティが悪いWEBサイトとはどのようなWEBサイトなのでしょうか?

次の項目で詳しく解説します。

クローラビリティが悪いWEBサイトの特徴

クローラビリティが悪いWEBサイトとは、検索エンジンのクローラーがサイト内のコンテンツを効率的かつ効果的に巡回・インデックスすることが困難なWEBサイトを指します。

このようなWEBサイトには、次のような特徴があります。

- クローラーが巡回しづらい仕様のWEBサイト

- クローラー巡回を妨げる問題が発生しているWEBサイト

- 品質が低いコンテンツが多いWEBサイト

それぞれ詳しく解説します。

クローラーが巡回しづらい仕様のWEBサイト

クローラーが巡回しづらい仕様や設定をおこなっているWEBサイトは、クローラーがスムーズにWEBサイト内を巡回できないため、クローラビリティが悪くなります。

クローラーが巡回しづらいWEBサイトの特徴として、次のものが挙げられます。

- サイト構造が複雑

- 内部リンクが不足している

- XMLサイトマップがないまたは不備がある

例えば、サイト構造が複雑なサイトはクローラーが階層の低いページにたどり着くまでに時間がかかるため、クロール効率が低下します。また、内部リンクが不足している場合は、クローラーがページ間をスムーズに移動できないためクローラビリティが悪くなります。

クローラー巡回を妨げる問題が発生しているWEBサイト

WEBサイトにGoogleのクローラーの巡回を妨げる何かしらの問題が発生している場合は、クローラーがページを閲覧できなかったり、閲覧するのに時間がかかるためクローラビリティが悪くなります。

クローラーの巡回を妨げる問題は、次のようなものが挙げられます。

- robots.txtの誤設定

- サーバーの応答速度が遅い

- IPブロックやアクセス制限がかかっている

- 500系や400系のサーバーエラーが頻発している

- ページの読み込み速度が遅い

契約しているサーバー会社の問題で、ネットワークに問題が発生している場合は仕方ありませんが、このような問題が発生する原因の多くは、基本的にサイト運営者側の設定ミスによるものです。

運営者側の問題でクローラビリティが悪くならないように、技術的な設定を見直しましょう。

品質が低いコンテンツが多いWEBサイト

コンテンツの品質が低いWEBサイトも、クローラビリティが悪くなります。検索エンジンはユーザーにとって役に立つページを検索結果に表示するため、品質が低いページが多く存在しているWEBサイトはクロールする重要性が低いと判断します。

具体的に、品質が低いコンテンツとは次のものです。

- 内容の薄いコンテンツ

- 他サイトの内容を引用、転載しているだけのページ

- サイト内で多く重複しているページ

- インターネット上の情報をただまとめただけのページ

上記のようなページで構成されているWEBサイトの場合は、検索結果に表示させる意味がないため、積極的にクロールがおこなわれず、クローラビリティが低下します。

クローラビリティを向上させる方法

クローラビリティを向上させるためには、次の方法をおこなうのが効果的です。

- ディレクトリ階層の浅いサイト構造にする

- GoogleサーチコンソールからXMLサイトマップを送信する

- 内部リンクを設置する

- パンくずリストを設置する

- ページの表示速度を改善する

- 重複コンテンツを1つにまとめる

- リダイレクトチェーンを避ける

- ステータスコード304(Not Modified)を活用する

- Googleサーチコンソールからクロールのリクエストをする

クローラビリティが悪化している原因に合わせて、最適な施策をおこなってください。

それぞれの項目について詳しく解説します。

ディレクトリ階層の浅いサイト構造にする

ディレクトリ階層が浅いサイト構造にすることで、クローラーがページを発見しやすくなるためクローラビリティが向上します。ディレクトリ階層は、WEBサイト内の異なる階層を表す構造のことで、URL内でスラッシュ(/)を使って表現されます。

分かりやすく、本ページのURL「https://white-link.com/sem-plus/crawlability/」で説明すると、トップページ→カテゴリページ→記事ページと/で区切られているため、3階層目になります。

https://www.example.com/phones/iphone-14

ディレクトリ階層が深い例https://www.example.com/category/electronics/phones/apple/iphone-14

一方で、ディレクトリ階層が深いページの場合、クローラーが目的のページにたどり着くまでに多くのリンクを辿る必要があるため、クロール効率が低下する可能性があります。

また、ユーザーにとってもページを見つけづらかったり、自分がどの階層のページにいるのか迷ってしまうためユーザビリティにも悪影響を及ぼしSEO評価が低下します。

ディレクトリ構造については、Googleの公式ドキュメント内でも次のように記載されています。

シンプルな URL 構造を作成する。論理的かつ人間が理解できる方法で URL を構成できるよう、コンテンツを分類します。

URL に関する問題の解決:Google における URL 構造のベスト プラクティス

基本的には、3クリック以内で全てのページに遷移できるディレクトリ構造が好ましいと言われているため、なるべく浅いディレクトリ構造を心がけ、クローラビリティに悪影響が出ないように気を付けましょう。

GoogleサーチコンソールからXMLサイトマップを送信する

GoogleサーチコンソールからXMLサイトマップを送信することで、GoogleはWEBサイト内にあるURLを把握できるため、クローラビリティが向上します。

XMLサイトマップとは、検索エンジンにWEBサイト内にあるページの存在やサイトの構造を伝えるためのファイルのことで、GoogleにクロールしてほしいURLを記述します。

GoogleのクローラーはWEBサイト内を自動的に巡回してくれるため、小規模なWEBサイトの場合はXMLサイトマップを送信する必要がありません。

つまり、XMLサイトマップを送信することでクローラビリティが向上するというわけです。

大規模サイトにXMLサイトマップを送信した例

※ XMLサイトマップを送信したことでクローラビリティが改善され、インデックスされたページが数十万単位で増加しています。

以下に該当するWEBサイトはXMLサイトマップを送信することで、クローラビリティが向上する可能性が高くなります。

- サイトの規模が大きい

- サイトが新しく、外部からのリンクが少ない

- サイトに動画や画像などのリッチメディア コンテンツが多数含まれている

- 複雑なサイト構造である

XMLサイトマップの作成方法と、Googleサーチコンソールに送信する方法については、別の記事で詳しく解説しています。

内部リンクを設置する

内部リンクを適切に設置することで、クローラビリティを向上させることができます。

内部リンクとは、ユーザーがWEBサイト内にある異なるページに移動できるようにするために、ページ同士を繋いでいるリンクのことです。

ユーザーが内部リンクを使ってページを移動するのと同じように、GoogleのクローラーもWEBページ上にある内部リンクを辿ってWEBサイト内を巡回し、クロールをおこなっています。

そのため、WEBサイト内にある全てのページにユーザーとクローラーが辿り着けるように内部リンクを設定することで、検索エンジンがWEBサイト内をスムーズに巡回できるようになりクローラビリティが向上します。

内部リンクを設定する際は、下記の様にルールを設けて設定するとユーザビリティとクローラビリティを向上させることができます。

- 重要なページへの内部リンクはグローバルナビやサイドナビに設定する

- 関連性の高いページ同士を内部リンクで繋ぐ

- 記事ページの内部リンクはユーザーの目的に沿って設置する

- トップページから全てのページに3クリック以内に移動できるようにする

- サイト内で、内部リンクを受けていない孤立したページを作らない

内部リンクを設置するコツは、ユーザーにとって使いやすいWEBサイトにするために必要な動線を作成してあげることです。ユーザーにとって使いやすいWEBサイトを意識することで、結果的にクローラーにとっても巡回しやすいクローラビリティの高いWEBサイトを構築できます。

内部リンクについては、別の記事で詳しく解説しています。

パンくずリストを設置する

パンくずリストとは、WEBサイト内の現在地を階層構造の形で示すためのナビゲーション機能の1つです。

パンくずリストは、「トップページ > カテゴリ > サブカテゴリ > 現在のページ」というようにページの道筋が表示されるため、ユーザーは上位階層に戻りやすくなるうえ、検索エンジンのクローラーにとってもサイト内のコンテンツ構造を把握しやすくなります。

また、Googleの検索エンジンは、パンくずリストを活用して内部リンクを発見し、クロールを行っています。そのため、すべてのページにパンくずリストを設置することで、クローラビリティを向上させることができます。

実際に、GoogleのJohn Mueller氏もパンくずリストについては、X(旧Twitter)で次のように回答しています。

”We use breadcrumbs for crawling (finding internal links) & for rich results (structured data);”

■ SEM Plus 和訳

クロール(内部リンクの検索)とリッチリザルト(構造化データ)にはパンくずリストを使用します。

なお、パンくずリストを設置する際に構造化データでマークアップをおこなうと、検索結果画面にリッチリザルトとして表示されるため、クローラビリティの向上だけでなく検索結果でのクリック率向上も期待できます。

パンくずリストについては、別の記事で詳しく解説しています。

ページの表示速度を改善する

ページ速度を改善することで、クローラビリティを向上させることができます。ページ速度とは、ユーザーがWEBサイトにアクセスしてから、ページが表示されるまでにかかる読み込み時間のことです。

表示速度が早いページは、ユーザーが快適にページを閲覧できるようになるのと同じように、Googleのクローラーも高速に表示されるページを効率よく巡回できます。

Googleのクローラーにはクロールをおこなう上限(クロールバジェット)が存在するため、Googleのクローラーが1つのWEBサイトをクロールできる時間には限りがあります。

例えば1秒間に1ページクロールできるとした場合、1分間にクロールできるページ数は60ページですが、表示速度が極端に遅く1ページクロールするのに10秒かかる場合は、1分間に6ページしかクロールできません。

表示速度が遅い場合は、クロールバジェットの限界に達してしまいクロールがおこなわれない状態になってしまい、クロールされていないページが発生する可能性があります。

ページの表示速度を改善するためには、以下の方法が有効です。

- 画像を圧縮する

- 不要なJavaScriptやCSSの読み込みを削減する

- サーバーやホスティングプランを見直す

- 不要なプラグインを削除する

- キャッシュ設定を見直す

小規模のサイトの場合は、クロールバジェットを気にする必要はありませんが、中規模以上のサイトの場合はクローラビリティに悪影響が出るので、表示速度を改善しておきましょう。

重複コンテンツを1つにまとめる

重複コンテンツを整理して統合することで、クローラビリティを向上させることができます。重複コンテンツとは、同じ内容が記載されているにも関わらずURLが異なるページのことです。

- http://example.com/shop/products/item/12345

- https://example.com/shop/products/item/12345

- https://www.example.com/shop/item/12345?color=red

- https://www.example.com/shop/item/12345?color=blue

上記のようにページの内容が重複している場合は、ユーザーが同じ情報を複数ページで見かける場合と同じように、Googleのクローラーも重複しているページのURLをそれぞれ巡回するため、無駄なクロールをおこなうことになります。

そのため、重複コンテンツを 1つにまとめて正規ページを定めることで、検索エンジンが本来クロールすべきページに集中できるようになり、クローラビリティが向上します。

重複する複数のページを統合する際は、下記の様にルールを設けて設定するとユーザビリティとクローラビリティを向上させることができます。

- 「Canonical」タグを使用して検索エンジンに正規ページを伝える

- 301リダイレクトを使ってURLを統合する

重複コンテンツの扱いについては、別の記事で詳しく解説しています。

リダイレクトチェーンを避ける

リダイレクトチェーンとは、あるページから別のページにリダイレクトした際、さらにまた別のページへリダイレクトが繰り返され目的のページに到達するまでに複数回のリダイレクトを経由してしまう状態のことです。

長いリダイレクトチェーンが発生していると、Googleのクローラーが余計なリソースを消費するため、クローラビリティに悪影響が出ます。

また、テストした結果では6回もしくは7回以上のリダイレクトチェーンの場合、クローラーがリダイレクト先のページを認識できないリダイレクトエラーが発生し、ページがインデックスされませんでした。

そのため、クローラビリティに悪影響を出さないように、WEBサイト内のリダイレクトが1回で済むように設定します。

リダイレクトチェーンが発生しているかどうかはブラウザ上では分かりづらいため、「HTTPステータス&リダイレクトチェッカー 」など、リダイレクトを調べることができるツールを使って確認しましょう。

ステータスコード304(Not Modified)を活用する

304ステータスコードを正しく活用することで、クローラビリティを向上させることができます。

304ステータスコードとは、サーバーが前回クロール時とコンテンツが変わっていない場合に返すステータスコードのことで、Googleのクローラーは304がサーバーから返ってきた場合は更新がないページと判断するため、不要なデータの再取得をしなくて済みます。

「更新されていないページにも毎回データを返す」ような状態が続けば、クローラーは無駄な通信や処理に時間を費やすことになり、新しいぺージや更新したページのクロールが後回しになってしまう可能性があります。

つまり、クローラビリティを向上させるためには、更新されていないページは304ステータスコードを返し、クローラーが更新されたページだけを重点的にクロールできるようにする必要があります。

Googleサーチコンソールからクロールのリクエストをする

Googleサーチコンソールからリクエストすることで、対象のURLをクロールしてもらうことができます。

クロールリクエストは1URLごとに1回ずつおこなわないといけないことと、1日に利用できる回数制限があるため、新しいページを公開した場合や、リライトをした場合にしか活用できませんが、リクエストをおこなえば確実にクロールしてもらうことができます。

Googleサーチコンソールからリクエストする方法は、以下になります。

- Googleサーチコンソールにログインします。

- ページ上部の検索窓にリクエストしたいURLを入力します。

- 「インデックス登録をリクエスト」をクリックします。

以上で完了です。

クローラーを指定のURLに呼ぶことができます。

URL検査ツールの使い方は、別の記事で詳しく解説しています。

クロール状況を確認する方法

クローラビリティの改善施策をおこなう前と後で、実際にどの程度改善されたのか確認してみましょう。Googleサーチコンソールを使うことで、自社のWEBサイトがどのくらいGoogle botにクロールされているかを確認できます。

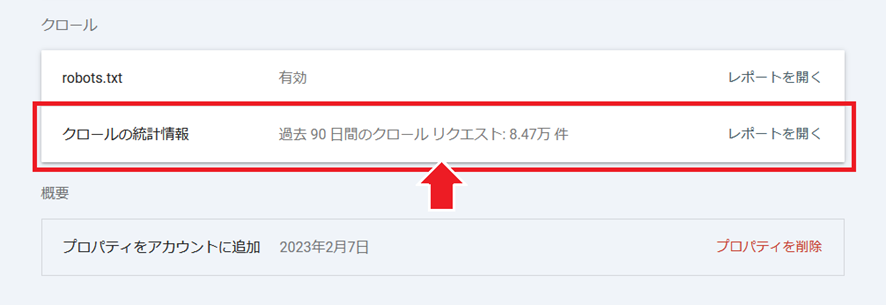

クローラビリティが改善されたかどうかを調べたい場合は、Googleサーチコンソールの機能「クロールの統計情報」で確認します。

Googleサーチコンソールにログインします。

左メニューの中から「設定」をクリックします。

「クロールの統計情報」の欄にある「レポートを開く」をクリックします。

クロールリクエストの合計数が表示されます。

クロールの統計情報はクロール数以外にも、ページの応答時間や、クロール中にダウンロードされたすべてのファイルとリソースの合計サイズなど、クロールに関する様々な情報を確認できます。

テクニカルな知識が必要になりますが、クローラビリティの改善施策をおこなったら、必ず確認して効果検証をおこないましょう。

クロールの統計情報については、別の記事で詳しく解説しています。

クローラビリティを改善した事例

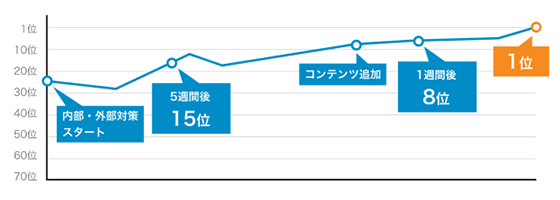

最後に弊社でデータベース型のWEBサイトで、クローラビリティを改善した事例を紹介します。

主に「表示速度の改善」「サーバーの見直し」「サイト構造の見直し」を中心に取り組んだ結果、検索エンジンのクローラーが効率的にサイトを巡回できるようになり、検索順位やアクセス数が向上したケースを紹介します。

【サイト概要】

| サイトの種類 | ポータルサイト |

| ユーザー数 | 月間PVが数万程度 |

| 課題 | WEBサイトのクローラービリティが悪かったため、一覧ページへのクロール量が少なく全ての一覧ページがクロールされていない状態 |

キャッシュ導入や画像の圧縮、遅延読み込み、不要スクリプト削除、CDN利用などでサーバーの負荷を低減。

改善施策②:クローラーの制御とサイト構造ファセットナビゲーションの絞り込みで生成される、インデックスさせる必要のない一覧ページのURLに対してrobots.txtやnoindexを使ってクローラーをブロック。深すぎるディレクトリが発生しないようにサイト構造の変更。

【施策後の結果】

まとめ

クローラビリティを向上させることは、結果的にユーザビリティの改善にも関係するため、SEOをおこなう上では重要な施策です。Googleには、1つのWEBサイトをクロールできる上限があるため、多くのページをインデックスさせる必要のある大規模サイトの場合は特に重要になります。

クローラビリティの改善施策はテクニカルな施策になりますが、その分効果も大きいため是非取組んでみてください。なお、自社内に技術者がいない場合や、どこから手を付けてよいか分からない場合は弊社まで気軽にお問合せください。

クローラビリティの改善に特化したクロール最適化代行をおこなっているため、WEBサイトの状況に合わせた最適化改善案をご提案させて頂きます。

ぜひ、読んで欲しい記事

SEO対策LLMO診断・無料でできるチェックリスト40項目【2025最新版】2025/07/07

SEO対策LLMO診断・無料でできるチェックリスト40項目【2025最新版】2025/07/072025/07/07

SEO対策「検出-インデックス未登録」がサーチコンソールに表示される原因と解決策2025/07/01

SEO対策「検出-インデックス未登録」がサーチコンソールに表示される原因と解決策2025/07/012025/07/01

SEO対策llms.txtとは?書き方やLLMOでの効果について解説2025/07/04

SEO対策llms.txtとは?書き方やLLMOでの効果について解説2025/07/042025/07/04

SEO対策サイトリニューアルがSEOに与える影響│順位下落防止のポイントを解説2025/06/24

SEO対策サイトリニューアルがSEOに与える影響│順位下落防止のポイントを解説2025/06/242025/06/24

SEO対策LLMO対策代行会社おすすめ9選|LLMOコンサルティング外注業者の選び方を解説2025/07/04

SEO対策LLMO対策代行会社おすすめ9選|LLMOコンサルティング外注業者の選び方を解説2025/07/042025/07/04

SEO対策403(Forbidden)エラーの意味とは?発生する原因と解決方法を解説2025/06/13

SEO対策403(Forbidden)エラーの意味とは?発生する原因と解決方法を解説2025/06/132025/06/13